Ściąganie dużych plików z serwisów hostingowych typu rapidgator.net, uploaded.net, catshare.net, rapidu.net, turbobit.net bez rejestracji i opłacenia konta premium, może trwać, ze względu na ograniczony transfer (zwykle do 100-200 KB/s) nawet kilka czy kilkanaście godzin. Przez ten czas komputer musiałby wiec być cały czas włączony. Pomyślałem więc, dlaczego nie wykorzystać do tego celu komendy wget odpalonej na routerze działającym pod kontrolą OpenWrt z podpiętym dyskiem USB. Router i tak cały czas jest włączony, a przez większość czasu się nudzi.

Zaczynamy sztuczki z wget

Jak wspomniałem na wstępie, do ściągania plików wykorzystamy oczywiście komendę wget. Problem polega jednak na tym, że serwisy hostingowe robią co mogą, aby wyeliminować możliwość ściągania plików przez boty, np. trzeba udowodnić, że jest się człowiekiem przepisując kod z obrazka CAPTCHA. No cóż, nie zapłaciliśmy za konto premium to powinniśmy chociaż obejrzeć reklamy sponsora naszego transferu.

Na szczęście komenda wget to potężne narzędzie, które pozwoli dokończyć proces ściągania. Tak „dokończyć”, ponieważ serwisu hostingowego nie sposób oszukać – cały proces weryfikacji naszego człowieczeństwa będziemy musieli wykonać w tradycyjnej, graficznej przeglądarce. W poniższym przykładzie będzie to Firefox.

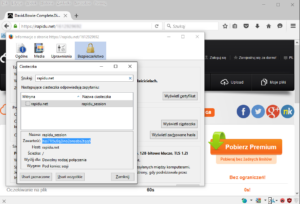

Tak więc przechodzimy pod adres pliku do ściągnięcia. Będzie to nasz referer. Dalej musimy sprawdzić identyfikator sesji zapisany w ciasteczku. W Firefoksie klikamy na Narzędzia -> Informacje o stronie -> Bezpieczeństwo – > Wyświetl ciasteczka. I spisujemy nazwę i wartość ciastka.

Ostatni krok to rozpoczęcie pobierania, które od razu możemy przerwać, a korzystając z menu kontekstowego, skopiujemy właściwy adres pliku.

Ostatnim argumentem jaki potrzebujemy do polecenia

wget jest user-agent zwykłej, graficznej przeglądarki. Tego nie trzeba za każdym razem zmieniać. W poniższym poleceniu został wykorzystany user-agent z aktualnej wersji Firefoksa. A jeśli chcesz sprawdzić user-agent swojej przeglądarki wejdź tutaj.

Gotowe polecenie powinno wyglądać mniej więcej tak:

wget --referer='https://rapidu.net/0123456789' --cookies=off --header "Cookie: rapidu_session=hss71l5u9q2ino2onsebs2tqq6" --user-agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:43.0) Gecko/20100101 Firefox/43.0' http://free6.rapiduservers.net/download/0123456789abcdef0123456789abcdef01234567/nazwa.pliku.do.ściągnięcia.rar &

Dla nieobytych w linuksowej konsoli, dodam jeszcze, że znak & pozwala na wykonanie polecenia w tle. Shell nie musi czekać na zakończenie procesu ściągania.